Glenn Kessler, le rédacteur en chef de la chronique de vérification des faits du Washington Post, soulignait déjà en 2019 :

« Nous avons vu une explosion de vidéos qui sont délibérément déformées, ou qui sont en train d'être montées d'une manière ou d'une autre pour changer la façon dont les gens voient ce qui s'est passé, cela va jusqu'aux deepfakes (…) Au cours des deux dernières années, nous avons étendu le factchecking aux vérifications de faits vidéo. Ils obtiennent cinq fois plus de vues que nos vérifications des faits de texte. C'est une indication du nombre de personnes supplémentaires qui obtiennent leurs informations par vidéo plutôt que par écrit » .

Depuis, les spéculations vont bon train quant aux dérives hypothétiques d’un tel outil mis entre les mains du premier venu. Cela flirte parfois avec la science-fiction mais nous allons tenter d’énumérer les plus vraisemblables et d’en analyser les risques potentiels.

L’un des premiers deepfakes européens a eu lieu en Belgique dès 2019 et même la Première ministre Sophie Wilmes en a été victime l’année suivante, sans conséquence sur la crédibilité de celle-ci. Mais en 2023 un rapport de la société Sumsub , entreprise anglaise de sécurité en ligne, annonce que la Belgique fait partie des pays les plus touchés par l’explosion des deepfakes voyant le nombre de fraudes par deepfake exploser de 2950 % cette année-là, presque autant que les Américains, avec +3000 % de cas.

Le sujet était relativement peu abordé en Europe avant 2022-23, en comparaison avec les craintes qu’il suscite aux États-Unis depuis cinq, six ans. Il faut dire que ce pays est encore sous le coup des élections de 2016 et du scandale Cambridge Analytica ou encore des immixtions russes dans ce processus électoral. Depuis l’élection de Donald Trump et le Brexit, les fake news cumulées aux données personnelles des citoyens sont vues comme une arme de propagande très tentante pour des équipes politiques à travers le monde. Beaucoup d’élites américaines se demandent quelles seraient dès lors les conséquences de vidéos truquées dans les campagnes à venir, d’autant que les dernières étaient de plus en plus nauséabondes. Rappelons que Donald Trump n’hésitait pas à déclarer qu’Obama n’était pas américain, à qualifier Hillary Clinton de « crooked » , « crapule » en français, Joe Biden de « sleeping Joe », Joe l’endormi, et Kamala Harris de « folle », de « stupide comme un roc » et de « clocharde ». Dès 2019, Trump était capable de partager à chaud sur Twitter des photos et des vidéos de désinformations, notamment à l’encontre de Nancy Pelosi, présidente démocrate de la Chambre des représentants. Mais l’usage des hypertrucages était resté anecdotique en politique jusqu’en 2024, année qui a vu leur multiplication et des élections pour la moitié de l’Humanité. D’autant que Trump est désormais soutenu par Elon Musk, un homme influent et peu regardant sur la véracité des informations qui circulent sur son réseau X (ex Twitter), tout comme sur l’utilisation de son IA Grok pour propager de la désinformation et des deepfakes. Le camp démocrate ne manque pas non plus de mordant et est capable, dans sa communication, de flirter avec les limites de la bienséance voire de la légalité.

Désormais ces trucages deviennent bluffant et se multiplient dans nombres de propagandes, d’arnaques ou d’intimidations. Et nous le verrons, les femmes en subissent de particulièrement perverses et violentes.

Internet est devenu l’empire de la désinformation et beaucoup de responsables et de spécialistes s’en inquiètent, allant jusqu’à parler « l’infocalypse » . Mais est-il vraiment raisonnable d’imaginer qu’un jour une majorité de citoyens, excités par la lumière bleue de leurs écrans, espérant y trouver la lune tels des papillons de nuit devant une ampoule incandescente, prendraient le risque d’y brûler les ailes de leur liberté démocratique ? Rien n’est moins sûr, même si pour beaucoup mieux vaut prévenir que guérir.

En revanche, ce qui est clair, c’est que le terrain numérique, source de débats polarisés et de croissance des partis extrémistes, est de plus en plus propice à une désinformation par l’image et/ou le son, avec un réalisme déconcertant. Le tout propagé à grande vitesse par des bots, des robots, chargés de les disséminer par millions.

« Un mensonge répété dix fois reste un mensonge, répété mille fois, il devient alors une vérité »,

cette phrase attribuée à Joseph Goebbels, l’un des plus implacables propagandistes de l’Histoire, résume assez bien une méthode qui a fait ses preuves.

Nous tentons dans cette publication d’évaluer les risques qui peuvent en découler et les facteurs pouvant favoriser leur croissance, que ce soit au niveau sociétal, économique ou politique. Car si cet outil peut offrir une part d’amusement ou de sensibilisation, on constate d’ores et déjà qu’il perfectionne principalement la tromperie, la fraude, la vilénie et le chantage.

À l’aune des inquiétudes d’experts de la question, nous analysons ensuite les pistes de solutions.

Mais commençons par comprendre ce que sont les deepfakes et quelle est leur origine.

Comme Saint-Thomas, beaucoup ne croient que ce que qu’ils voient. Et dans notre monde de l’image toute puissante, les deepfakes risquent d’en déstabiliser plus d’un. Le terme est un mélange de fake news, soit une désinformation intentionnelle, et de deep learning, qui désigne un type d’intelligence artificielle où la machine « apprend » par elle-même, à partir de sa propre observation de divers phénomènes. On appelle ces derniers des algorithmes d’apprentissage, par opposition aux algorithmes de programmation qui se contentent d’exécuter des ordres donnés.

« Ce sont des faux, quelle que soit la nature du contenu – vidéo, photo, audio ou texte – conçus grâce à l’intelligence artificielle (…) Pour l’heure, les deepfakes les plus couramment diffusés sur internet sont des vidéos truquées dans lesquelles le visage et la voix d’une personne connue sont falsifiés, lui faisant dire ou faire ce qu’elle n’a jamais dit ou jamais fait ».

Attention il s’agit bien d’un hypertrucage et non d’une astuce de montage, de type ralenti ou coupure d’une partie du discours, que beaucoup ont tendance à englober dans le terme deepfake et que d’autres nomment cheapfake (littéralement « le faux bon marché »). Par exemple si on coupe une partie du discours d’un homme politique pour lui faire dire autre chose.

On savait que les hypertrucages vidéos étaient possibles après avoir vu au cinéma Forrest Gump serrer la main de JFK ou lorsque, dans le film « Rogue One, une histoire de Star Wars », sorti en 2016, avec le personnage de Grand Moff, réapparu sous les traits de Peter Cushing, l’acteur qui l’avait incarné dans un épisode précédent de la saga et mort… en 1994, soit vingt-deux ans auparavant. Tout cela était fait par des studios professionnels avec d’énormes puissances de calcul pour modifier chaque image d’une vidéo. Ça demandait aussi de gros investissements ce qui limitait leur nombre et leur impact. Mais ça, c’était avant.

Les évolutions technologiques, susceptibles de faire évoluer les deepfakes, explosent depuis quelques années et ne cessent de surprendre par leur réalisme grandissant. Ces progrès ont pu être réalisés, à la base, grâce à une technique appelée GAN (Generative Adversarial Networks) soit des Réseaux Antagonistes Génératifs en français. Il s’agit en fait d’une classe d'algorithmes d'apprentissages non-supervisés par l’homme. En clair, deux réseaux sont placés en compétition. Le premier réseau est le « générateur », il génère par exemple une image, tandis que son adversaire, le « discriminateur » essaie de détecter si l’image est réelle, à partir de sa base de données d’images, ou bien si elle est le résultat du générateur. Ces deux réseaux s’entraînent l’un l’autre dans le cadre d’une relation contradictoire, s’échangeant les données et les résultats de leurs analyses. Les deux algorithmes entretiennent donc une relation gagnant-gagnant d’amélioration continue.

Wintics, start-up parisienne qui travaille sur l’intelligence artificielle et le deep learning au service notamment de la mobilité urbaine explique assez bien cette technologie :

« Prenons l’exemple des faussaires de billets de banque traqués par les policiers. Le Générateur joue le rôle d’un faussaire qui produit une liasse de 100 faux billets de banque (dont les designs sont tous différents). Il la présente à un policier (le Discriminateur) qui, grâce à l’observation d’une base de données de billets authentiques qui lui a été transmise, a des connaissances basiques en identification de billets contrefaits. Le policier va donc analyser les billets du faussaire et les classer en deux catégories : ceux qu’il pense être vrais et ceux qu’il pense être faux. A chaque fois qu’un faux billet est identifié par le policier, celui-ci est renvoyé au faussaire. Cela va permettre à ce-dernier de connaitre les designs qui n’ont pas été capables de tromper la police et par symétrie, ceux qui ont été assez réalistes pour passer à travers les contrôles. Par cette logique d’apprentissage, le faussaire va pouvoir créer de nouveaux billets plus réalistes et les représenter au policier. Celui-ci donnera une nouvelle fois son verdict et ainsi de suite. Le processus s’arrête lorsque le faussaire (le Générateur) est capable de créer des billets qui trompent le policier (le Discriminateur) à tous les coups » .

Les GAN peuvent ainsi par exemple faire évoluer des designs en fonction de contraintes physiques ou augmenter la résolution d’une image.

Et Wintics de conclure : « Avec l’apparition des GAN, la Data Science s’est dotée d’un formidable outil de création et s’attaque ainsi à ce qui semblait être un des derniers prés carrés de l’intelligence humaine ».

Comme l’expliquait l’un des spécialistes belges de la question, Charles Cuvelliez, professeur à l’École polytechnique de Bruxelles (ULB), sur les ondes de la RTBF, les deepfakes peuvent être déclinés en trois catégories :

Fin 2017, un développeur, se faisant appeler Deepfakes sur le forum Reddit , avait réussi à insérer des visages de célébrités dans des films pornographiques. Il a ainsi conçu « un programme capable d’automatiser ce processus, en se basant notamment sur une technologie d’IA mise à disposition gratuitement par Google, nommée Tensorflow. Son système, « nourri » de centaines de photos et de vidéos de la star choisie glanées sur le Web, est ensuite capable de déformer suffisamment le visage d’une actrice de film pornographique pour qu’elle ressemble au modèle qu’a « appris » le programme . Puis ce fut un autre internaute qui mit en ligne « un programme similaire, ne nécessitant pas de compétences pointues. C’est alors l’emballement : les internautes s’emparent de ce logiciel nommé FakeApp, gratuit, et se mettent à publier en masse leurs créations, aidés par des modes d’emploi détaillés » . Au fil des expériences de chacun, le programme se perfectionne et des bases de données d’images de stars, indispensables à la création de ces vidéos, sont partagées. Car pour arriver à un résultat satisfaisant, il fallait disposer d’un grand nombre d’images, les personnalités publiques étaient donc particulièrement visées. Déjà « en 2018 une entreprise du secteur avait même annoncé pouvoir insérer ses clients dans leurs vidéos favorites accompagnés des actrices « de leur choix » .

Le principe, appelé « face swapping » (échange de visages) ne se limitera bien sûr pas aux films érotiques ou pornographiques. Des visages, dans des scènes de films cultes, seront par exemple remplacés par d’autres et les déclinaisons vont se multiplier.

Et il ne faut pas aller jusqu’aux États-Unis pour trouver des amateurs de ce type de trucage vidéo. L’un des premiers deepfake de l’histoire aurait été fait en Belgique. Dans un reportage de M6 de mars 2019, l’anversois Sven Charleer présente ainsi ses vidéos dans lesquelles il s’amuse à placer le visage de sa femme sur le corps de l’actrice américaine Anne Hathaway. Il déclare lui-même :

« C’est un outil très puissant, entre de mauvaises mains il peut être destructeur. Je pense qu’on ne réalise pas son pouvoir. »

Heureusement les deepfakes qu’il réalise sont encore décelables pour qui s’y attarde un peu.

Puis la technique n’a cessé d’évoluer. L’application Zao a fait parler d’elle à l’été 2019. C’est une application mobile qui permettait de réaliser très facilement du face swapping. Il suffisait à l’application d’une seule photo de notre visage, ou d’une petite vidéo pour un meilleur effet, pour que notre tête soit transposée sur celle d’un acteur, dans une séquence vidéo déterminée, et ce en quelques secondes. Des millions de gens se sont ensuite amusés à placer des visages sur des clips, des films, des vidéos grâce à FaceApp, Zao, Morphin ou Reface app. Cette dernière application, lancée par l’entreprise ukrainienne Reface AI, a fait le buzz à l’été 2020. En quelques jours, elle s’est hissée à la première place du classement des meilleurs téléchargements sur le PlayStore. Il suffisait de faire un selfie et de sélectionner le clip dans lequel vous vouliez intégrer votre visage. Bien sûr ces quelques minutes d’amusement s’échangent contre une utilisation par ces sociétés, qu’elles soient chinoises ou ukrainiennes, des informations et photos fournies. De quoi fournir une belle base de données de reconnaissance faciale, mais c’est un autre débat.

Désormais, des sites comme Undress AI ou PTool proposent de placer des visages sur des photos de femmes nues. Des sites qui ventent leur facilité d’utilisation. Un jeu d’enfants. Nous verrons que cela peut représenter de sérieux dangers démocratiques et humains.

Ici, on ne se contente pas de mettre un visage sur le corps d’un autre, c’est le discours qui est modifié. L’une des premières techniques était celle du Lip sync, pour synchronisation labiale, qui consistait à ne modifier que les lèvres, et leurs contours, d’une personne pour les adapter à un autre discours. L’une des plus connues est celle où on voit Barak Obama insulter Donald Trump. Le trucage, révélé au public en avril 2018, a été fait par le réalisateur et comédien Jordan Peele, avec Adobe After Effects, un logiciel vidéo facilement disponible, et FakeApp. L’objectif poursuivi était d’éveiller les consciences aux problèmes des deepfakes.

Les hypertrucages ne sont bien sûr pas l’apanage de pirates. De nombreux débouchés leur sont trouvés comme corriger le bafouillement d’un acteur dans une prise de tournage ciné. Dès 2019, une équipe de chercheurs de l’Université de Stanford, de l’Institut Max Planck, de l’Université de Princeton et d’Adobe Research avait déjà mis au point

« une version simplifiée de ces trucages, avec l'aide des développeurs des logiciels Adobe » .

A l’aide d’une vidéo existante et suffisamment longue de quelqu’un en train de parler, on peut donc lui faire dire d’autres choses de façon assez naturelle. Même des transitions de mouvements de mains ou de corps sont bluffantes. Pour les besoins de leur démonstration, les scientifiques ont transformé la célèbre phrase tirée du film Apocalypse Now « j’aime l’odeur du napalm au petit matin » en « j’aime l’odeur du pain grillé au petit matin ». Impossible de distinguer l’original de la supercherie » .

Plus fort encore, le "face2face" a permis, dès 2016 déjà, de falsifier une vidéo quasiment en direct. Grâce à l’approche conçue par des étudiants allemands et américains , on utilise un acteur source comme vous et moi pour faire faire les mêmes mouvements et expressions à une vidéo d’un acteur cible. N’importe qui peut ainsi servir d’acteur source pour faire faire des grimaces à une vidéo de Vladimir Poutine, par exemple.

« Il ne s'agit plus de coller son visage sur celui d'une star dans un blockbuster hollywoodien, mais d’animer" le visage d'une personnalité avec des mimiques et des paroles inventées, ce qui pourrait par exemple permettre de produire une fausse conférence de presse d'un chef d'État, le tout en direct. »,

s’inquiète Camille Toussaint, journaliste à la RTBF .

Soulignons aussi l’arrivée d’Avatarify, un programme qui superpose le visage de quelqu'un d'autre au vôtre en temps réel, lors de visioconférences. Tout le monde peut ainsi avoir par exemple le visage d’Elon Musk pendant une conférence sur Zoom ou Skype.

Diverses technologies, susceptibles de faire gagner en qualité les deepfakes, évoluent ainsi en parallèle comme l’application Lyrebird qui développe son propre outil de clonage des voix. En avril 2018, Lyrebird annonçait avoir développé une technologie d’intelligence artificielle capable d’imiter n’importe quelle voix en se basant sur un enregistrement « d’une minute seulement ».

Depuis, l’IA a révolutionné l’accessibilité aux deepfakes. Le célèbre ChatGPT a ouvert le bal et des applications comme Midjourney ou DALL-E ont connu un succès colossal. Nous n’avons pas tardé à voir de fausses images d’Emmanuel Macron en train de ramasser des poubelles dans Paris, du pape François en doudoune blanche ou encore de Donald Trump en tenue orange de prisonnier US. Des photos satiriques qui ont permis à beaucoup de monde de prendre connaissance du phénomène deepfake en Belgique, et ça n’est pas plus mal. On a pu voir également quantité de photos de quidams, sur lesquelles ils s’étaient transformés en rockeur, en viking, en personnage de série culte ou en train de faire un selfie avec Albert Einstein. Des applications plutôt ludiques de manière générale et essentiellement de photos. Car des sites nous proposent de créer nos deepfakes quasi en direct, comme deep-fake.ai qui nous annonce

« Deep-Fake.ai propose deux fonctionnalités intéressantes : l'image deepfake et la vidéo deepfake. Alors que la fonctionnalité d'image deepfake est déjà disponible, la fonctionnalité vidéo deepfake est actuellement en préparation et sera bientôt publiée. Restez à l'écoute pour cet ajout passionnant qui permettra aux utilisateurs de créer des vidéos deepfake réalistes et captivantes en un rien de temps ».

Nous verrons par la suite les éventuels risques que cela peut représenter, notamment une fausse vidéo jointe à une fausse voix qui peuvent tromper bien des gens inattentifs.

Certains se sont peut-être déjà amusés à chercher lequel des deux visages proposés en photo sur www.whichfaceisreal.com/ était réel. A chaque fois un des deux individus est créé de toute pièce.

« Les résultats du jeu « Which Face Is Real ? », mis en ligne par deux professeurs de l’université de Washington, Jevin West et Carl Bergstrom, afin de tester la technologie de Nvidia, ne sont pas rassurants. Sur 6 millions de parties jouées par 500 000 personnes, le taux de réussite est de 60 % dès le premier essai mais ne dépasse pas 75 % avec de l’entraînement ».

Et ces personnes ultra réalistes fabriquées de toutes pièces grâce au GAN, peuvent désormais être animées en vidéo. Et d’après Charles Cuvelliez, ce sont les deepfakes les plus difficiles à déceler.

La technologie de pointe derrière ces vidéos, a une gamme d'applications commerciales, en particulier dans les industries créatives telles que la publicité, le champ artistique ou la réalisation de films. Les publicités et les campagnes peuvent être plus facilement doublées, les contraintes de temps des acteurs peuvent être réduites et les effets spéciaux peuvent être créés plus rapidement et en toute sécurité. Des campagnes de sensibilisation peuvent également mettre en image une réalité future ou une situation hypothétique.

Citons cette jolie initiative du musée Salvador Dali de Floride qui a redonné vie à l’artiste espagnol sur écran pour accueillir les visiteurs. Le résultat est bluffant. On peut même faire un selfie avec lui. Côté belge, on n’est pas en reste. Christopher Ume, et sa société Metaphysic, qui s’est fait connaître avec des deepfakes de Tom Cruise devenues virales sur Tik Tok , a créé l’événement en 2022 dans la célèbre émission de télé crochet américaine America’s got Talent. Il y a notamment fait chanter les membres du jury sur grand écran aux côtés d’Elvis Presley, le tout via la technique deepfake. Le public et le jury ont adoré. Et il y a fort à parier qu’on reverra ce style de show mêlant des personnalités du passé à d’autres actuelles, voire même à des personnages tout à fait imaginaires. L’IA n’a pas fini de nous surprendre.

Mais d’étranges déclinaisons voient également le jour. Exemple récent, en février 2024, un article du journal Le Monde titrait

« TikTok et le business des récits de faits divers dopés au deepfake … Un visage, appartenant à une personne réelle ou fictive et animé par l’IA, vous fait de la voyance, raconte un fait divers glauque ou un récit incroyable. Le Monde a ainsi recensé une centaine de comptes TikTok spécialisés dans ce format, dont certains affichent plusieurs centaines de milliers d’abonnés, et des vidéos en français, arabe, anglais, espagnol, allemand ou italien qui cumulent parfois des millions de vues » .

Le deepfake est ainsi utilisé pour ajouter de la crédibilité au récit. Voir un criminel raconter ses horreurs paraît ainsi intéresser les amateurs du genre, même si cela reste une initiative quelque peu glauque.

« TikTok travaille également sur une nouvelle option qui permettrait aux marques de déployer des influenceurs virtuels pour promouvoir leurs articles. Ces derniers seraient en mesure de vendre les produits via des vidéos et des diffusions en direct » .

Mais cette tendance semble mieux acceptée par les consommateurs asiatiques qu’européens, pour le moment.

Il faut dire que des deepfakes, présentateurs de journaux télévisés ou influenceurs créés de toute pièce peuvent travailler 24h/24 sans se fatiguer. La technique peut également rendre les jeux vidéo hyperréalistes et plus immersifs. Avoir son visage sur un héros de jeu pourfendant le mal sera certainement prisé par les amateurs. Ces personnages pourraient même être transposés à nos profils sur les réseaux sociaux, donnant une image idéalisée de ce que nous voulons montrer de nous.

Du côté de la mode et des achats en ligne, les débouchés sont nombreux. Vous pouvez essayer virtuellement les articles qui vous plaisent.

« Afflelou, Optic 2000 ou encore Atol offrent à leurs clients la possibilité d’essayer leurs lunettes depuis chez eux. De son côté, l’entreprise SuitUs propose une cabine d’essayage en ligne pour les marques de vêtements. Cette technologie crée un double corporel pour diminuer de 50% le nombre de retours lié au e-commerce » .

Si les possibilités utiles sont nombreuses, nous allons nous intéresser à présent aux divers dangers que peuvent représenter les hypertrucages.

Le succès des fake news sur le net a surpris par son ampleur et par l’irrationalité de nombreuses d’entre-elles. Des réactions émotionnelles ont permis à certaines de faire un buzz à plusieurs millions de vues. Avec la possibilité de créer de la vidéo et du son, beaucoup craignent encore plus les dérives à l’échelle de la planète, qu’elles soient sociétales (incitations au désordre social, influence sur les pratiques et les pensées des citoyens), criminelles (la falsification de preuves, l’extorsion, la fraude ou encore les problèmes de droits d’auteur), sociétales (harcèlement, l’intimidation). Voici les scénarios de risques possibles, certains plus réalistes que d’autres. À chacun d’en juger.

Qui dit nouvel outil, dit nouvelles possibilités. Parmi celles-ci, se trouvent souvent des moyens de se faire de l’argent illégalement ou d’être tenté de flirter avec des lois inadaptées et/ou archaïques.

Pour l’instant, il s’agit surtout d’amusement, en mettant par exemple le visage de Silvester Stallone sur le corps d’Arnold Schwarzenegger ou celui de Di Caprio sur notre propre corps.

Mais, à l’instar des fake news, on peut aisément imaginer des deepfakes créés pour faire du clic sur le dos de personnalités, et donc ramener des revenus publicitaires intéressants tout en profitant d’un bon référencement sur Google. On a ainsi vu nombre de fake news être bien plus rentables que des vraies dans le domaine politique. Des vidéos, sorties de leur contexte, ont ainsi surfé sur la polarisation des débats sur les réseaux sociaux et connu un gros succès. Pendant la campagne présidentielle américaine de 2016, n’a-t-on pas vu Paul Horner, appelé le roi des fake news , avouer détester Trump, tout en propageant nombre d’absurdités à propos d’Obama ou d’Hillary Clinton. Son explication était simple, pour lui les anti-Démocrates étaient ceux qui relayaient le plus d’infos sans les vérifier. Il produisait donc les infos qui rapportaient et tant pis si des gens étaient assez idiots pour les croire. Pour lui, il n’y avait pas d’intention de nuire dans ses actes. On peut imaginer une transposition du phénomène, faux audios et/ou vidéos à l’appui.

D’ailleurs on a aussi pu voir, début 2023, dans un hypertrucage devenu viral (10,5 millions de vues), Elon Musk avouer, face caméra, s’être drogué et expliquer être prêt à imaginer de « nouvelles voitures spatiales » et à conquérir Mars . C’était en fait un canular d’un habitué du genre, lancé sur Twitter, qui aura quand même fait 7,5 millions de vues. Mais combien de personnes y auront cru, impossible de le savoir. Le plaisantin aura en tout cas fait le buzz et un peu d’argent.

Par ailleurs, les influenceur.se.s deepfakes permettent d’aller encore plus loin pour vendre et attirer des followers. Début 2024, on a beaucoup parlé d’Adrianna Avellino, influenceuse générée par une intelligence artificielle (IA). Elle cumulait plus de 94.000 abonnés sur son compte. Sur son profil, un lien vers une page Fanvue, concurrent d'Onlyfans, avec des photos d'elle dénudée, moyennant un abonnement de cinq dollars par mois. Pour ce faire,

« selon le média américain 404media, des dizaines de vidéos d'utilisatrices Instagram ont été volées sans leur consentement et détournées pour remplacer leur visage, par celui d'Adriana. Avec, à la clé, des millions de likes et d'abonnés ».

Des cas qui se multiplient avec des comptes totalisant des centaines de milliers de followers et des millions de vues,

« en utilisant "presque exclusivement" du contenu volé. Selon le média américain Manofmany, les influenceurs IA gagnent en moyenne 3.200 à 11.000 dollars sur Onlyfans ».

Des deepfakes tellement bien réalisés qu’ils sont devenus difficiles à détecter pour les followers. Et quand ces comptes sont signalés, puis supprimés par les plateformes, d’autres apparaissent rapidement.

Il est à parier que, pour faire de l’argent, nombre d’idées vont encore voir le jour, deepfakes à l’appui.

Durant la pandémie de COVID, les solutions numériques aux problèmes ont explosé et, par la force des choses, la fraude en ligne aussi. La démocratisation des deepfakes a provoqué un boum des manipulations et des arnaques. Imaginez, par exemple, un parent recevoir un coup de fil de son enfant en difficulté et qui a besoin qu’on lui envoie de l’argent immédiatement. Par ailleurs, un militaire ou un employé pourrait-il refuser d’obéir à l’ordre d’un faux supérieur hiérarchique en vidéo conférence ? L’exemple, bien que déjà ancien, de Gilbert Chikli est significatif dans ce cas de figure. En 2005-2006 l’homme s’est fait passer pour le PDG de grandes entreprises auprès de cadres et leur demandait, par téléphone, de lui transmettre des centaines de milliers d’euros. Il a ainsi réussi à dérober plusieurs millions d’euros à des dizaines de grands groupes bancaires et industriels. Appelé « arnaque au président », la technique a fait de nombreux émules depuis, révolution de l’IA et imitation de voix deepfake à l’appui. Et en mars 2019, le Wall Street Journal annonçait que des criminels avaient utilisé pour la première fois un logiciel basé sur l'intelligence artificielle pour usurper l'identité d'un chef de direction et exiger un transfert frauduleux de 220.000 €. . Début 2020, ce sont 35 millions de dollars qui semblent avoir été dérobés à une banque émiratie de Hong-Kong . Faux mails, faux papiers, et surtout… fausse voix de directeur d’entreprise simulée par ordinateur. Plus fort encore, et toujours à Hong-Kong, début 2024 : le salarié d'une grande multinationale reçoit un mail de son directeur financier, basé à Londres, lui demandant d’effectuer de gros transferts. L’employé est méfiant mais sera vite rassuré par une visioconférence dans laquelle il reconnaît ses collègues et effectuera pour 26 millions de dollars de transferts. On s’apercevra qu’il avait parlé à … des avatars. Les fraudeurs avaient trouvé des vidéos et des audios accessibles au public via YouTube, puis utilisé les technologies deepfake et IA pour imiter leurs voix.

On a vu pendant la pandémie le nombre d’arnaques, d’hameçonnages et autres usurpation d’identité se multiplier sur le net. Les hypertrucages et l’IA ont considérablement perfectionné leur crédibilité apparente.

Le phénomène des brouteurs , qui font de l’arnaque aux sentiments, souvent depuis l’Afrique, pourraient avoir de beaux jours devant lui avec les deepfakes. Se faire passer pour quelqu’un d’autre devient de plus en plus facile. Un homme inscrit dans un CPAS hennuyer, nous expliquait récemment avoir perdu près de 1000€ en croyant parler à une ravissante jeune femme, alors qu’il était dans une détresse affective, suite à un divorce.

Désormais les usurpations d’identité sont légions. Des personnes se font soutirer de l’argent en pensant avoir affaire à Florent Pagny ou à Conner Rousseau. Deux espagnoles ont ainsi perdu 325.000€, pensant entretenir une relation privilégiée avec Brad Pitt. Les malfrats avaient profilé et ciblé les deux femmes. Ils ont heureusement été arrêté mais ce qui interpelle, c’est que

« Pour trouver leurs victimes, les cybercriminels ont étudié les réseaux sociaux des femmes. Ils ont même dressé un profil psychologique d'elles … Ils ont découvert que les deux femmes étaient des personnes vulnérables, en état de dépression et en manque d'affection.»

Deepfakes et profilages rendent désormais l’arsenal des escrocs particulièrement efficace et déstabilisant.

C’est l’un des grands débats du moment. Utiliser le deepfake pour imiter la voix, parfois avec l’image en plus, d’une chanteuse ou d’un chanteur, en a fait bondir quelques-uns dans le monde musical. Le 14 avril 2023, on découvrait sur YouTube, TikTok et d’autres plateformes, la chanson Heart on my sleeve, chantée par les Canadiens Drake et The Weeknd. Elle a rapidement fait le buzz le temps d’un week-end,

« avant que les artistes concernés et leur maison de disques, Universal Music Group, dénoncent un « fake » et obligent les plates-formes à le retirer dare-dare. Une contrefaçon confirmée au même moment par un faussaire anonyme, du nom de Ghostwriter977, écrivant dans un commentaire vidéo avoir utilisé l’intelligence artificielle (IA) pour générer les voix des deux vedettes. « J’ai été pendant des années auteur anonyme payé des clopinettes pour le plus grand profit des majors. Voici l’avenir », narguait-il » .

Depuis, les plagiats n’ont plus cessé, d’Angèle à Jay-Z, jusqu’à faire revivre des chanteurs décédés comme Frank Sinatra ou Michael Jackson. Comment gérer les droits d’auteur d’un.e chanteur.se si sa voix et son style sont plagiés par quiconque ? On peut éventuellement entendre le côté amusant de la parodie, et imaginer faire danser et chanter « La danse des canards » à Taylor Swift, mais faire un gros succès sur les réseaux avec une fausse chanson de Billie Eilish. Le principe flirte avec l’usurpation d’identité.

Au-delà du côté divertissant, The Guardian s’interroge sur les conséquences de ces deepfakes pour l’industrie musicale. Car OpenAI est loin d’être le seul acteur à s’intéresser aux algorithmes générateurs de musique. Google a créé en 2016 le projet Magenta, dont le but est de mettre au point des intelligences artificielles créatives. Spotify s'est doté d'un Creator Technology Research lab, à l'origine de « Hello World », premier album composé avec une IA. En 2023, des fans d’Oasis, fatigués d’attendre une réconciliation des frères Gallagher et une reformation du groupe, ont tout simplement sorti eux-mêmes un album intitulé AIsis (Contraction d’Oasis et de AI) : The lost tapes, et produit à partir de mélodies emblématiques de Liam Gallagher et de voix générées par ordinateur. Les fans sont ravis mais les Gallagher peuvent-ils réclamer des droits d’auteur sur cette imitation, respectueuse du travail des deux frères ennemis ?

Et puis, si les stars ont les moyens de lancer des poursuites judiciaires, les artistes moins connus ne risquent-ils pas de se faire plagier facilement ? Sera-t-il encore judicieux de mettre sa maquette ou son morceau en ligne pour se faire connaître sans risquer de se la faire voler ?

Aujourd’hui, avec l’IA Uberduck, vous choisissez la voix d’une star de la musique puis vous saisissez le texte qu’elle doit prononcer et le tour est joué. Il faut juste promettre que ça ne sera pas utilisé à des fins commerciales.

A terme, chacun pourrait se créer sa, voire ses, propre.s chanson.s . Ou l’IA pourrait carrément vous créer une chanson personnalisée en fonction de votre humeur, ce qui est désormais réaliste au vu des masses de données de plus en plus disponibles pour alimenter les algorithmes d’apprentissages ? Les possibilités sont tellement vertigineuses, qu’il est difficile d’anticiper les réactions et acceptations du public, auxquelles s’adaptera inévitablement l’industrie et la technologie IA. Il faudra légiférer en conséquence mais ça ne sera pas simple au vu des évolutions permanentes.

En 2021 était lancé le Métavers de Mark Zuckerberg, qui nous avait imaginé un monde virtuel avec des avatars et une économie parallèle où on pouvait s’acheter une maison ou des NFT (œuvres virtuelles), se faire de nouveaux amis et épater la galerie à grand renfort de bitcoins. Mais ce concept élaboré en 1992 par Neal Stephenson, dans le roman de science-fiction « Le Samouraï virtuel », un livre culte pour les entrepreneurs de la Silicon Valley, fut un flop retentissant pour Mark Zuckerberg. Cela dit, à ce jour, plusieurs centaines de métavers peuvent déjà être recensés et les plus grands (Roblox, Second Life, Zepeto, Minecraft, Fortnite) regroupent des millions d’utilisateurs.

Le concept est aussi vague que fourre-tout. Le rapport interministériel français de la mission sur le développement des métavers, publié en octobre 2022 , définit ce dernier comme

« un service en ligne donnant accès à des simulations d’espaces 3D en temps réel, partagées et persistantes, dans lesquelles on peut vivre ensemble des expériences immersives ».

Malgré l’échec de Meta, l’idée persiste et de nombreuses entreprises comme Microsoft, Amazon ou Google investissent dans le concept. « Un rapport récent du cabinet McKinsey évalue à 5.000 milliards de dollars le marché du métavers à l’horizon 2030, soit l’équivalent de la troisième économie mondiale derrière les États-Unis et la Chine. Les investissements sont évalués à plus de 120 milliards de dollars. Le projet métavers dépasse les ambitions d’une seule entreprise, aussi grande soit-elle … de grandes marques, comme « Nike, Balenciaga ou Louis Vuitton se sont positionnées dans ces espaces virtuels » . De son côté Mark Zuckerberg n’envisage pas le Métavers rentable avant 2030.

Ces projets permettraient de créer une économie parallèle, en bitcoins, difficile à surveiller pour les États, et de se créer une vie parallèle « plus fun » dans laquelle les deepfakes et l’IA auraient une grande place à jouer. Une belle opportunité pour se faire connaître, que l’on soit une grande marque ou un artiste inconnu. D’autres y voient carrément l’avenir du télétravail . En tout cas, le concept ne séduit pas encore beaucoup de monde, il est d’ailleurs encore assez méconnu voire flou.

Mais n’est-il pas plus simple de jouer à un jeu vidéo immersif avec un casque de réalité virtuelle ? D’autant que ces mondes parallèles du Métavers risquent d’augmenter un peu plus la dépendance à ces vies virtuelles, au détriment d’une vie sociale et d’une économie locale. Sans compter que la plongée dans ces univers trop parfaits peut entraîner déception, voire dégoût de son physique et de sa propre personne, des dérives déjà observées sur Insta et sur TikTok . Sans parler de la perte de perceptions des expressions faciales des autres êtres humains, par exemple et de l’empathie. Dans son fameux livre, Alone together (Seuls ensemble, L’Echappée, 2015), la chercheuse Sherry Turkle, psychologue et professeur au Massachusetts Institute of Technology, constate que la connexion incessante avec les robots et les ordinateurs dévore les relations humaines en face-à-face et affaiblit l’empathie.

Si le métavers devenait une réalité, il pourrait accélérer la déliquescence du tissu social, affaiblir l’empathie humaine et nous conduire à rêver notre vie plutôt que de la vivre vraiment et rompre les liens sociaux qui sont une des bases fondamentales de notre humanité.

L’IA permet désormais, grâce aux milliers de données laissées sur le net par un proche, de faire « revivre » celui-ci après son décès. Le thème de l’immortalité est un vieux fantasme et le deuil d’un être cher est une des choses les plus difficiles à accepter, il suffit de voir le succès de certains voyants communiquant avec les esprits. Le sujet est pernicieux car, converser avec un aïeul pour comprendre ses racines peut être vraiment intéressant. C’est ce que propose

« HereAfter AI, une société basée aux États-Unis qui permet aux gens de « télécharger leurs souvenirs, qui sont ensuite transformés en un « avatar d’histoire de vie » avec lequel les amis et la famille peuvent communiquer » .

Cette méthode permet aux gens de laisser leurs souvenirs pour les générations futures. Mais que les datas laissées sur le net soient représentatives de qui était la personne semble excessif. N’oublions pas que, comme le précise Amélie Cordier, ingénieure et maîtresse de conférences en intelligence artificielle à l’Université Lyon I : «

On prête à l’intelligence artificielle des idées, des pouvoirs, des applications qui ne sont en fait ni plus ni moins que des désirs, des vœux d’êtres humains. Le mot important dans tout ça, c’est “simulation”. Avec ces intelligences artificielles génératives, qu’on n’avait pas jusqu’à maintenant, effectivement, il est possible de simuler le fait qu’une personne que l’on connaisse puisse parler. Et l’IA permet de faire ça avec une qualité de simulation qui est vraiment très intéressante. Mais ce n’est ni plus ni moins la même chose que de se dire : « Je vais parler avec un personnage de jeu vidéo. »

Pour le « Dr Kirsten Smith, chargée de recherche clinique à l’Université d’Oxford,

le risque est que ces avatars de défunts nous maintiennent accrochés au passé, nous rendent incapables d’aller de l’avant et de mener normalement notre vie » .

Le danger de conséquences psychologiques est bien réel.

Autre manière de prendre ses simulations pour des réalités, en 2022, une femme de 87 ans a carrément assisté à ses propres funérailles au Royaume-Uni, grâce à une startup appelée StoryFile, qui enregistre des séquences vidéo et audio avant le décès d'une personne. Elle les rend ensuite interactives grâce à la puissance de l'intelligence artificielle et d'un avatar holographique.

Au royaume de l’IA et du deepfakes, la fantaisie humaine semble être un bel exemple de l’infini.

Diverses associations ont aussi compris tout l’intérêt des hypertrucages pour des campagnes de sensibilisation dites positives.

Exemple chez nous, en mars 2020, avec un discours vidéo fictif de Sophie Wilmès publié sur les réseaux sociaux pour relancer les actions du groupement d'activistes écologistes Extinction Rebellion. La Première ministre y déclarait :

« La pandémie actuelle de Covid-19 plonge ses racines dans la destruction écologique mondiale et ce sont les plus vulnérables dans nos sociétés qui sont le plus durement frappé·e·s ».

Une vidéo qui a été largement diffusée sur les médias sociaux et dans les médias main stream, sans doute en raison de sa nouveauté et de son originalité. En effet, jamais on n’avait détourné la vidéo d’un ou d’une premier.e ministre belge via un deepfake, d’autant que le message allait plutôt à l’encontre du discours plutôt libéral de celle-ci. L’objectif a donc été atteint pour l’association écologiste.

Ces campagnes de sensibilisation dites positives sont aussi accusées de jouer avec le feu. En octobre 2019, « l’association Solidarité Sida a mis en ligne une vidéo du président des États-Unis Donald Trump. « Le sida, c’est fini », semble déclarer ce dernier. Mais, il s’agissait en fait d’un acteur dont le visage avait été numériquement modifié pour laisser entrevoir la possibilité d’un « monde sans sida », comme l’explique Antoine de Caunes, le président d’honneur de l’association, à la fin de la vidéo. Beaucoup d’internautes s’y sont cependant laissé prendre et ont critiqué une campagne qui joue avec les limites du réel à des fins de communication. Le clip a été vu 3,5 millions de fois en quelques heures et a sans doute touché son public cible : les jeunes. Le directeur fondateur de l’association Solidarité Sida, Luc Barruet, prête à cette vidéo truquée

« des vertus pédagogiques, pour que les gens mesurent ce que l’on peut faire avec les deepfakes » .

À ses yeux, les critiques émises sur le Net, quant au caractère « douteux » ou « dangereux » de cette fausse vidéo dont il faut attendre la fin pour en comprendre le sens, sont peu nombreuses en comparaison de son succès viral, précisant que

« ceux qui réagissent sur les réseaux sociaux sont toujours ceux qui ne sont pas contents, pas ceux qui trouvent ça formidable » .

Le deepfake peut ainsi être très utile pour éveiller les consciences sur différents sujets mais ces vidéos fabriquées peuvent se retourner contre l’intention de départ ou être sorties de leur contexte initial, en tout ou en partie. Ainsi en 2018, en Inde, une vidéo a longtemps circulé dans tout le pays et effrayé les Indiens.

« Elle montre deux hommes à moto qui s'approchent d'un groupe d'enfants qui jouent au cricket. La moto ralentit, le passager attrape l'un des enfants et ils prennent tous deux la fuite. Un procédé rapide et terrifiant. Sauf que cette vidéo ne décrit en aucun cas un fait réel. C'est même l'opposé : ce clip fait partie d'une campagne de prévention contre les enlèvements d'enfants, et pas en Inde, mais au Pakistan. (…) La vidéo a circulé sur WhatsApp et dans l'État du Goujarat, à l'ouest du pays, accompagné du message d'alerte suivant, prétendument issu par la police : “un gang de 300 enleveurs d'enfants est arrivé dans la région, protégez vos enfants !” ».

Des dizaines de personnes suspectées d’être kidnappeurs ont été tabassées par la population et de janvier à juillet 2018, une trentaine de personnes sont mortes, lynchées par des foules. La police a été dépassée par le phénomène, d’autant que l’info a été diffusée sur WhatsApp, qui est une messagerie cryptée et donc quasiment impossible à intercepter. Un simple détournement d’une vidéo de sensibilisation sur fond de tension sociale aura ainsi provoqué plusieurs dizaines de morts.

Une multiplication excessive de vidéos fictives pourrait également desservir la cause s’il n’est pas précisé systématiquement à l’image que la vidéo est un faux. Mais cela peut être camouflé pour être détourné, à l’instar de cet exemple indien.

Il est certain que le deepfake est une magnifique opportunité pour tous de faire de la satire. Elle sera de bon ou de mauvais goût et elle sera différemment acceptée selon son point de vue. A l’instar du deepfake qui a fait danser la princesse Leonor, héritière d’Espagne, sur TikTok. Beaucoup y ont cru et ont ensuite trouvé la blague de mauvais goût car l’utilisation de l’image de la princesse avait été réalisée de manière trompeuse. Il aurait mieux valu souligner qu’il s’agissait d’un faux.

Et encore, lorsque la chaîne de télévision britannique Channel 4 suscite la controverse à Noël avec une vidéo «deepfake», diffusée vendredi 25 décembre, qui tourne en dérision le traditionnel discours de la reine Elizabeth II et le font terminer par un jerk endiablé de la Reine , les sujets de Sa Majesté ont crié à l'outrage, malgré les bonnes intentions clamées par la chaîne.

A l’heure où n’importe qui peut se prendre pour un caricaturiste de Charlie Hebdo, nul doute que la justice de nombreux pays va avoir fort à faire dans les prochaines années pour trancher et fixer les limites de l’amusement et de l’humiliation. Enfin, si elle en reçoit les moyens.

Au niveau judiciaire, la notion de preuve risque d’être quelque peu ébranlée. Ainsi, le premier cas de deepfake invoqué dans un procès en France, l’a été par le célèbre humoriste polémique Dieudonné. Dans une vidéo, publiée le 8 avril 2020 sur YouTube puis retirée, on le voyait critiquer vigoureusement les réquisitions d’une magistrate de Nanterre, la comparant notamment aux femmes ayant collaboré avec le régime nazi. Pour sa défense, il avait déclaré que cette vidéo était un deepfake. « Aujourd’hui, avec les deepfake, l’image n’est plus une preuve », avait plaidé son avocat David de Stefano, demandant sa relaxe. La cour a finalement quand même condamné Dieudonné à 30.000 euros d’amende ne jugeant pas cet argument crédible.

A l’inverse, ce faits-divers, aux États-Unis, qui souligne combien le deepfake s’immisce dans toutes les sphères de nos sociétés. Raffaela Spone est accusée d’avoir harcelé trois adolescentes, à l’aide d’images manipulées, pour leur faire abandonner leur rôle dans l’équipe locale de Cheerleading (l’équipe de supportrice) du comté de Bucks en Pennsylvanie. La mère de famille encourait jusqu’à un an de prison et les médias ont largement contribué à populariser l’affaire. Après presqu’un an de procédure, Matthew Weintraub, le procureur du district du comté de Bucks a annoncé abandonner les poursuites contre Raffaela Spone, la police ayant été incapable de fournir les preuves d’une quelconque manipulation de la vidéo.

Faudra-t-il bientôt prouver, de manière irréfutable, qu’un faux est faux et qu’un vrai est un vrai ? La justice n’a pas fini de devoir adapter les lois à ces nouvelles technologies, en mutation perpétuelles.

Un outil deepfake, permettant aux utilisateurs d'animer d'anciennes photos de proches, a été largement utilisé sur le site MyHeritage, site de généalogie permettant de retrouver ses aïeux. Au vu du succès, le site a désormais ajouté LiveStory, qui permet d'y insérer des voix.

En télévision, Thierry Ardison propose des interviews d’artistes décédés comme Dalida ou Jean Gabin grâce aux hypertrucages et au talent de comédiens.

Ces exemples soulignent qu’on pourrait tenter de faire croire qu’une personnalité n’est pas morte à l’aide d’une fausse vidéo, du moins pendant quelques temps. Pourrait-on aussi faire dire n’importe quoi au passé ? Sans aucun doute. La preuve ? « En juillet 1969, en cas d’échec tragique de la mission lunaire Apollo 11, le président américain Richard Nixon avait prévu un discours. Des chercheurs du Massachusetts Institute of Technology (MIT) en ont fait une vidéo . Objectif : démontrer les dangers des hypertrucages, qui permettent de faire dire à une personne des mots qu’elle n’a jamais prononcés. Cette expérience montre ainsi qu’on peut imaginer un faux discours de Nixon prétendant qu’Armstrong et Aldrin n’ont jamais mis le pied sur la lune et il est fort à parier que la vidéo serait largement partagée au regard du nombre de sceptiques face à ce moment de l’histoire. Une enquête IFOP a ainsi démontré qu’en 2019, un Français sur dix croyait que les Américains n'avaient jamais marché sur la lune.

Nos sociétés ne se construisent-elles pas sur des mythes fondateurs comme le fait que Charlemagne aurait inventé l’école ou que son ami Rolland aurait été tué par des Sarrasins, alors que c’était par des Basques. Et que dire de « Nos ancêtres les Gaulois », idée répandue aux XIXe et XXe siècles par les nationalistes français, à une époque où les peuples d'Europe cherchaient à se donner une ascendance antique, pour justifier l'existence de leur État-Nation. Mais ces mythes étaient fondateurs d’un pays, d’une population acceptant de vivre ensemble et de croire en un récit commun, et non d’une vague croyance partagée par des personnes éparpillées aux quatre coins du monde et sans aucune cohérence existentielle.

En fait, les deepfakes risquent bien d’alimenter les prétendues preuves des complotistes et des négationnistes de tout bord, qu’elles soient sonores, scripturales ou visuelles.

Au-delà de la difficulté pour les journalistes de dénouer le vrai du faux avec l’arrivée des deepfakes et de l’IA, comme nous le verrons plus tard, les hypertrucages peuvent devenir une tentation professionnelle pour ceux-ci. L’IA est effectivement de plus en plus utilisée par les journalistes, notamment pour la retranscription ou la traduction d’interviews ou encore pour une aide à la rédaction, à la correction des articles, au résumé ou à l’analyse de dossiers complexes. Mais à vouloir gagner du temps, ils doivent faire attention à la limite, parfois fragile, entre "les super assistants" et la manipulation.

En Belgique des journalistes débattent sur le sujet. Selon Yves Thiran, journaliste et membre d’un groupe de réflexion sur ces nouvelles technologies au sein de la RTBF, interrogé par Martin Bilterijs :

« C’est tout ce qui est la production de contenus. Que ce soit du contenu sous forme de texte, d’image ou de vidéo. A la RTBF, on s’abstient pour l’instant. Mais on voit bien que d’autres médias ont déjà commencé, notamment quand il s’agit d’illustrer un article sur un site web et qu’il n’y a pas l’image de l’événement. Traditionnellement, on utilise des images prétextes, mais là on demande à l’ordinateur de fabriquer l’image. C’est une des questions qu’on se pose : doit-on ou pas s’autoriser ce genre de productions ? … Un site américain a d’ailleurs dénombré “49 médias désormais entièrement automatisés”. Des sites qui génèrent des articles entièrement créés par l’intelligence artificielle. Ce sont “des médias de niche pas encore de grands médias”

, précise Yves Thiran.

Par ailleurs, le choix d’une image réelle, pour illustrer un article, reste un choix rédactionnel, en fonction d’une volonté de sensationnalisme par exemple. Mais créer une image en fonction de ce qu’on connaît d’un événement peut devenir beaucoup trop subjectif.

Il est également difficile de reconnaître une photo hyper truquée, même pour des professionnels. On se rappelle de cette photo qui avait gagné le prix du Sony World Photography Awards en 2023, avant que l’artiste ne révèle qu’il s’agissait d’un deepfake. Les journalistes doivent garder la capacité de ne pas être trompés par des images qui leurs seraient envoyées par de faux témoins d’un événement.

Mais n’oublions pas ce que nous entendons en atelier d’éducation permanente ou en formation. Les participants nous révèlent préférer les articles courts et faciles à comprendre, voire même ne sélectionner que les bonnes nouvelles. L’info tend à devenir irréversiblement un produit de consommation comme un autre pour de plus en plus de citoyens. Pourtant l’actualité est souvent complexe et nuancée et ne peut être une simple distraction. Les journalistes ont sans doute une carte à jouer en restant gages de qualité et de vérification des faits. Gageons qu’on leur en laisse les moyens car il est difficile d’imaginer que l’IA puisse complètement remplacer un journaliste, avec son talent de plume, sa créativité, son recul, son expérience, son humour, sa perception de la vérité, sa probité, son éthique, et tout ce qui fait l’âme d’un être pensant neutre et indépendant.

En matière de harcèlement, les deepfakes sont malheureusement plus efficaces qu’ailleurs, surtout envers les femmes.

« D’après un rapport de l’entreprise hollandaise de cybersécurité Deeptrace Lab, sur les 14.000 vidéos hypertruquées mises en ligne en 2019, 96% d’entre elles étaient à caractère pornographique ... De nombreuses célébrités comme Billie Eilish, Emma Watson ou encore d’autres streameuses de la plateforme Twitch en ont été les victimes. Car l’autre constat alarmant de Deeptrace Lab est que le deepfake pornographique cible exclusivement des femmes. Les deepfakes non pornographiques analysés sur YouTube contenaient, quant à eux, une majorité de sujets masculins » .

Et pour les femmes, cela est souvent dévastateur.

En Belgique, nous sommes loin d’être à l’abri car les exemples se multiplient. Fin 2023, Julia, 21 ans, étudiante belge en marketing et mannequin semi-professionnelle, reçoit des photos d’elle nue, pour lesquelles elle n’a jamais posé. Les photos sont tellement bien faites qu’elle est abasourdie :

« J'avais déjà entendu parler des deepfakes et des deepnudes (...) Mais je n’en avais pas conscience plus que ça avant que ça ne m'arrive à moi. C'était un événement un peu anecdotique qui se passait dans la vie des autres, mais qui ne se passerait pas dans la mienne » .

La jeune femme dépose plainte au commissariat. Il est vrai que des lois peuvent être invoquées, comme celles sur le voyeurisme et la diffusion non consentie, ou comme la directive européenne sur les violences faites aux femmes . Mais on prévient Julia

« que le “parquet est débordé” et qu’il y a “très peu de chances” que sa plainte aboutisse » .

Autre exemple, à la même époque, c’est Céline Van Ouytsel, miss Belgique 2020 qui en était victime :

« Je savais que cela se faisait parfois avec des stars de Hollywood très célèbres, mais je n’aurais jamais pensé que cela puisse m’arriver un jour. Comme quoi, cela peut arriver à n’importe qui… » .

Aucune femme publique n’est à l’abri. C’est par exemple arrivé à la célèbre influenceuse française Léna Situation. Elle explique :

« Ils ont mis un screen du vlog et le reste du corps ne m’appartient pas. Et il y a tellement de meufs sur internet qui vivent ça. C’est vraiment dégueulasse. Ça fait longtemps que je n’ai pas eu un moment que j’ai kiffé en tapant mon nom sur les réseaux sociaux. De bon matin, voir ma tête sur un corps nu ?! » .

Février 2023, dans un direct diffusé le 2 février dernier sur la plateforme Twitch, QTCinderella, une streameuse (une joueuse qui transmet et commente ses parties de jeux vidéo en direct) américaine de 28 ans, revient en larmes sur le deepfake à caractère pornographique dont elle a été victime :

"C’est à ça que ressemble la douleur. Voilà ce que cela fait de se sentir violée, abusée et de se voir nue contre sa volonté partout sur internet" .

Une victime australienne, va également déclarer à Euronews "C'est une condamnation à vie … Elle peut détruire la vie des gens, leurs moyens de subsistance, leur employabilité, leurs relations interpersonnelles, leurs relations amoureuses. Et il y a très, très peu de choses que l'on puisse faire une fois que quelqu'un est pris pour cible".

Il y a, d’ailleurs, fort à parier que des cas de chantages risquent de se multiplier pour un certain nombre de quidams. Combien préféreront payer 100, 200 voire 300€ plutôt que de voir circuler sur le net des deep nudes ou deep porns ?

Ironie supplémentaire, les deepnudes d’hommes sont non seulement rares, mais ils sont également de moindre qualité.

« Les algorithmes sont entraînés spécifiquement sur le corps des femmes … Cela révèle une inégalité plus profonde entre les sexes, un manque de respect pour les femmes et la violence sexuelle dans la société. La technologie ne fait qu’encourager l’objectivation des femmes. De plus, il ne s’agit pas toujours de satisfaire un fantasme. Une fausse vidéo porno peut aussi être utilisée pour réduire les femmes au silence. ».

Déjà, en 2018, l’histoire vécue en Inde par Rana Ayyub, a fait froid dans le dos des femmes engagées en politique indienne. Cette journaliste d'investigation a été la victime d'une vidéo « deepfake » à caractère pornographique qui a circulé sur les réseaux sociaux, notamment grâce à l'aide d'hommes politiques d’après une de ses sources. Très vite, elle reçoit des menaces de viol. Un tweet est diffusé sur les réseaux sociaux avec une capture d'écran de la vidéo et son numéro à côté, disant

« Salut, c'est mon numéro et je suis disponible ici ». « Les gens ont commencé à m'envoyer des messages WhatsApp me demandant mes tarifs pour le sexe ». « J'ai été envoyée à l'hôpital avec des palpitations cardiaques et de l'anxiété, le médecin m'a donné des médicaments. Mais je vomissais, ma tension artérielle a monté en flèche, mon corps avait réagi si violemment au stress »

, a-t-elle déclaré .

« Le pays tout entier regardait en boucle une vidéo porno que l'on m'attribuait et j'étais tétanisée » .

« Si vous étiez le pire misogyne du monde, cette technologie vous permettrait de réaliser tout ce que vous voulez »,

a déclaré Mary Anne Franks, professeur de droit à l'Université de Miami et présidente de l'association Cyber Civil Rights Initiative dont la mission est de venir en aide aux personnes victimes d'abus sur Internet partout dans le monde. »

L’histoire de Rana Ayyub fait ainsi craindre le pire pour les femmes qui mènent des combats politiques et/ou idéologiques à travers le monde, notamment face à une misogynie persistante. Cela dit, les hommes risquent de ne pas être épargnés non plus, quand on sait qu’une vie ou qu’une carrière politique peut dépendre d’une vidéo, à l’instar de celle, à caractère sexuel et partagée sur les réseaux sociaux, qui a conduit le candidat français Benjamin Griveaux à renoncer à la mairie de Paris en février 2019 avant même que l’authenticité des images n’ait pu être prouvée. Un deepfake pourrait avoir cet effet.

Heureusement, des femmes sont prêtes à se battre pour faire évoluer les lois. C’est le cas de la présentatrice tv hollandaise, Welmoed Sijtsma, qui s’est retrouvée dans un deep porn. En novembre 2023, le tribunal d’Amsterdam a condamné son auteur, un homme de 39 ans, à 180 heures de travaux d’intérêt général avec sursis. Son père avait refusé de regarder la vidéo, de peur de garder ces images en tête. Car n’oublions pas les dégâts collatéraux de ces images sur l’entourage des victimes, lui aussi souvent désemparé et frustré par un sentiment d’impuissance face à un phénomène nouveau, violent et excessivement intrusif.

Un tiers des élèves de la FWB serait concerné par le harcèlement, et un « programme-cadre » de prévention du harcèlement et d’amélioration du climat scolaire a été lancé. Il est effectivement difficile de protéger les jeunes des messages de haine, des harcèlement ou encore des images pornographiques, voire pédopornographiques, tout comme des arnaques et des réseaux de propagandes mensongères. La mode depuis peu : les deep nudes dans les écoles. En Belgique,

« une dizaine de jeunes filles de 12 à 16 ans, élèves du collège Saint-Remacle de Stavelot, ont été victimes de deepfakes. Des garçons de leur école et d’autres établissements scolaires ont récupéré les photos qu’elles postaient sur les réseaux sociaux. En utilisant l’intelligence artificielle, ils ont modifié ces photos pour faire apparaître ces adolescentes entièrement nues. Les images ont ensuite été partagées sur Snapchat ».

Une « nouvelle mode » qui tourne parfois au racket, au chantage et/ou au rançonnage. D’autant que ces images sont d’une facilité désormais déconcertante à réaliser. « Déshabillez n'importe qui, déshabillez les filles gratuitement », c’est le slogan de l'application ClothOff, qui a fait parler d’elle en Espagne récemment. Elle permet aux utilisateurs « de “déshabiller” n'importe quelle personne apparaissant dans la galerie de photos de leur téléphone. Il en coûte 10 euros pour créer 25 images de nus » . Une application qui a donné des idées de chantages à quelques ados d’une école d'Almendralejo, une ville du sud de l'Espagne, où une vingtaine de jeunes filles ont vu passer de fausses photos d'elles nues. En clair, si une adolescente ne payait pas une petite rançon, un faux nu d’elle était publié sur les réseaux. Un faux qui a des chances de devenir viral dans leur école, à minima. Ce cas est une ‘sextorsion’ mais il peut tout à fait s’agir de revanche ou de volonté d’humiliation d’une jeune personne. Et quand il s’agit de jeunes, voire d’enfants, les lois y sont encore moins préparées. Dans une interview accordée à Euronews, relatant ces faits , Manuel Cancio, professeur de droit pénal à l'Université autonome de Madrid,

« souligne qu'il existe un vide juridique car l'utilisation du visage de mineurs sur des photographies porte atteinte à leur vie privée, mais lorsqu'il s'agit de crimes dans lesquels des images intimes sont diffusées, c'est l'image dans son ensemble qui porte atteinte à la vie privée » mais « Comme elle est générée par deepfake, la vie privée de la personne en question n'est pas affectée. L'effet qu'elle produit (sur la victime) peut être très similaire à celui d'une vraie photo de nu, mais la loi est en retard »,

ajoute-t-il. La loi, espagnole en l’occurrence, est en retard, une phrase qu’on a pas fini d’entendre. Ce cas de chantage entre ados, nous apprend également que la plus jeune des victimes n’avait que onze ans et combien la manière de qualifier les faits ne fait pas l’unanimité parmi les avocats :

« il peut s'agir de pédopornographie, de crimes contre l'intégrité morale ou de distribution d'images à contenu sexuel non consensuel » .

L’année dernière, Child Focus a ouvert pour la première fois un certain nombre de dossiers sur les deepnudes.

« L’augmentation du phénomène nous inquiète, déclare Niels Van Paemel, conseiller politique. Grâce à notre service d’assistance téléphonique, nous recevons de plus en plus de questions de la part de jeunes sur des images truquées, qui se sont effectivement retrouvées dans les écoles. C’est le point de basculement que nous redoutions. Les deepnudes sont au carrefour du genre, de la cyberintimidation, de l’exposition (NDLR: diffusion numérique d’images privées sans autorisation dans le but de nuire ou d’humilier la personne représentée), de l’exploitation sexuelle et de la maltraitance des enfants. Tout y est réuni. » .

Nous le verrons plus loin des solutions existent mais sont complexes à mettre en place.

Les attaques et discréditations politiques se multiplient déjà dans le monde. On a vu passer une vidéo de Mauricio Macri, président argentin de 2015 à 2019, avec le visage d’Adolf Hitler ou un faux d'Inés Arrimadas, membre du Parlement de la Catalogne, superposé sur une vidéo pornographique. Est-ce une déclinaison moderne de la caricature ? Non, car on joue ici sur un hyper réalisme avec lequel un dessin n’essaie pas de rivaliser. En revanche pourrait-on présenter la vidéo de M. Macri comme de la satire ? En mai 1968 ne voyait-on pas une affiche présenter A. Hitler derrière le masque de Charles De Gaulle ? Il s’agirait ici d’une opinion politique tandis que la vidéo d’Inés Arrimadas ne peut être considérée comme telle.

Où mettre la limite ?

En mai 2019 un « deepfake » peu sophistiqué, plutôt appelé cheapfake (un faux ‘bon marché’), avait fait parler de lui aux Etats-Unis. On y voyait la présidente de la Chambre des représentants américaine, et farouche opposante à Donald Trump, Nancy Pelosi parler avec un phrasé hésitant qui donnait l'impression qu’elle était passablement éméchée, droguée, malade, voire hébétée. Une vidéo qui a eu le temps d’être partagée trois millions de fois avant que le Washington Post n’ait le temps de comparer la vidéo avec l’original et de constater que les images avaient simplement été ralenties de 25%. Même Rudy Giuliani, le propre avocat du Président Trump, avait eu le temps de la partager. Cela permet de souligner l’importance du “biais de confirmation” dans le phénomène des partages de vidéos truquées, même de façon grossière : lorsqu’une vidéo semble prouver quelque chose à laquelle ils croient déjà, les internautes penseront plus volontiers que la vidéo est réelle, ou n’en auront cure, et la partageront. Quand bien même une vidéo aurait été mise en ligne comme satire, au départ.

Mais si les deepfakes étaient plutôt rares dans les campagnes électorales jusqu’ici, l’année 2024 a vu la moitié de la planète aller voter et le nombre de deepfakes politiques se multiplier.

Aux États-Unis, ce sont des hypertrucages audios qui ont fait parler d’eux. Dès janvier, un étonnant appel automatique a été reçu par 5.000 électeurs du New Hampshire.

« Au bout du fil, la voix de Joe Biden qui, dans un message préenregistré, leur déconseillait d’aller voter aux primaires démocrates américaines du mardi 23 janvier. « Votre vote fera la différence en novembre, pas ce mardi (…) Voter ce mardi ne fera qu’aider les républicains à faire réélire Donald Trump. » C’était un faux : la voix de Joe Biden a été imitée par intelligence artificielle. Un deepfake politique qui a généré beaucoup d’émoi aux Etats-Unis ». L’auteur a été découvert un mois plus tard. Steve Kramer, consultant pour la campagne d’un rival de Joe Biden, s’est défendu en argumentant que son initiative avait justement pour objectif de mettre en lumière les dangers de l’intelligence artificielle en politique. « C’était une façon pour moi de faire la différence, et ça a marché », a-t-il déclaré à NBC. « Pour 500 dollars, j’ai obtenu un effet équivalent à 5 millions de dollars ».

Quelques mois plus tard c’est Elon Musk, ardent défenseur de Donald Trump qui partageait un deepfake de la candidate démocrate en train de dire des choses telles que « « Moi, Kamala Harris, je suis votre candidate démocrate à la présidence parce que Joe Biden a finalement révélé sa sénilité lors du débat » contre Donald Trump, explique la voix générée par IA dans la vidéo. Dans cette campagne artificielle, l’on peut entendre la fausse Kamala Harris affirmer qu’elle est une « recrue de la diversité », qu’émettre la moindre critique contre elle est « sexiste » ou « raciste » et qu’elle ne connaissait « rien à la gestion du pays ». La vidéo, qui arbore le logo « Harris for President », n’a jamais été signalée par Elon Musk comme étant générée par l’IA. L’affaire a remis au premier plan la responsabilité des réseaux sociaux dans la diffusion de ces contenus. Surtout que X déclare interdire

« le partage de médias synthétiques, manipulés ou hors contexte qui peuvent tromper ou dérouter les gens et entraîner des préjudices »

, à l'exception des mèmes et de la satire « à condition qu'ils ne provoquent pas de confusion significative quant à l'authenticité des médias ». Même pour de la satire, il semble tout à fait déplacé d’utiliser une vidéo d’une personne sans son consentement, surtout avec une vidéo hyperréaliste.

A la veille des élections présidentielle, les autorités américaines ont pris très au sérieux ce genre d’affaires. Tout comme en Europe, comme nous le verrons plus loin.

Il faut dire qu’aux États-Unis, des clans complotistes s’affrontent. Les Q-Anon, sympathisants de Trump, qui croient que des personnalités influentes sont impliquées dans des réseaux pédophiles internationaux, qu’elles veulent créer un nouvel ordre mondial dans lequel les États auraient abandonné leur souveraineté au profit de cette élite, et que seul Donald Trump pourrait les contrer, s’il est réélu. Comme réponse à l’absurdité de cette théorie, des sympathisants démocrates ont aussi créé une mouvance complotiste appelée BlueAnon, qui s’approprie l’univers et les codes de QAnon tout en inversant la cible. Ils entendent ainsi Lutter contre « l’État profond » qui veut « détruire la candidature du président Biden » (de Kamala Harris désormais) et « ramener Trump au pouvoir le 5 novembre ». Affirmant que les médias refusent de relayer des révélations contenues dans de nouveaux documents rendus publics, impliquant Donald Trump dans le réseau de trafic sexuel de mineures du financier et prédateur sexuel Jeffrey Epstein. Le tout étayé par … une photo deepfake. Quelques incohérences au niveau des doigts de certaines mains et de la longueur du bras de la jeune fille de gauche ont confirmé qu’il s’agissait bien d’un deepfake.

Côté européen, à l’approche des élections de 2024, on a pu découvrir Amandine Le Pen et Léna Maréchal sur TikTok. Deux sympathiques avatars sexy avec les visages rajeunis de Marine Le Pen et celui de sa nièce de Reconquête, Marion Maréchal. Deux profils deepfakes qui faisaient la promotion de l’extrême droite en présentant une image glamour, jeune et moderne du parti grâce à de faux contenus générés par l’IA. Très bien faites, ces vidéos reprenaient les codes TikTok qui plaisent à la jeune génération : des musiques tendances, accompagnées de chorégraphies réalisées par des jeunes filles, bien souvent sur fond de paysages clinquants. Le tout en mettant en avant leur plastique avantageuse et accompagné de commentaire de type :

« Quand le RN sera élu », « Moi quand je vais voter Reconquête en juin », « La robe que je vais porter pour la victoire de Jordan (Bardella) » …

Si l’on peut croire à de simples comptes parodiques créés pour faire sourire les internautes, ils semblent bien avoir été créés pour les tromper et faire la publicité du Rassemblement national auprès des jeunes utilisateurs. On pouvait même leur verser de l’argent. Les deux femmes politiques parodiées ont réfuté tout lien avec ces comptes. Car il est difficile de faire des liens entre ce genre de comptes et les campagnes de partis. Voilà une utilisation des deepfakes dans une campagne qui est simple, bon marché mais à l’efficacité difficilement quantifiable, mis à part les 30.000 abonnés chacune.

Plus troublant,

« En Slovaquie, en mars 2024, une fausse conversation générée par IA mettait en scène la journaliste Monika Tódová et le dirigeant du parti progressiste slovaque Michal Semecka fomentant une fraude électorale. Les enregistrements diffusés sur les réseaux sociaux pourraient avoir influencé le résultat de l’élection. Le même mois, en Angleterre, une soi-disant fuite sur X fait entendre Keir Starmer, le leader de l’opposition travailliste, insultant des membres de son équipe. Et ce, le jour même de l’ouverture de la conférence de son parti. Un hypertrucage vu plus d’un million de fois en ligne en quelques jours. »

Dans nos démocraties, le sujet des deepfakes est relativement bien pris au sérieux, que ce soit par nos politiques ou nos journalistes. Les alertes sont régulièrement lancées quand des photos ou des vidéos truquées sont mises en ligne. En revanche, certains gouvernements sont moins regardants.

Exemple avec cette utilisation beaucoup plus dérangeante, celle du pouvoir en place au Vénézuela. L’équipe du président Maduro en use et abuse. Les Vénézuéliens ont ainsi pu profiter de deux avatars, pseudo présentateurs de journal télévisé, vantant le renouveau de l’économie du pays. Une vision idéalisée du programme présidentiel pour contrer les déclarations des autres médias.

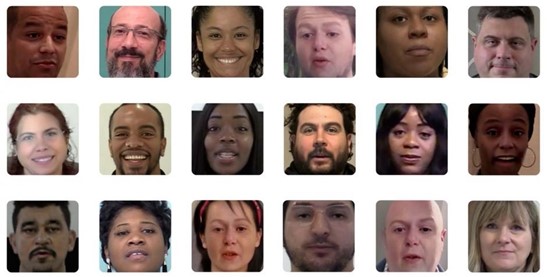

« Les présentateurs de House of News, Noah et Daren, ont été sélectionné parmi plus d’une centaine de visages multiethniques disponibles sur le software Synthesia ... Mais ce vaste catalogue humain ne propose pas uniquement des journalistes comme Noah et Daren. On peut choisir un Dave avec un look de médecin ou de cadre supérieur, un Carlo avec des vêtements de travail et un casque et même le père Noël » .

La propagande chez un dictateur n’est pas neuve, dans les années 1970 et 1980 les JT sur l’OZRT, l’Office Zaïrois de Radio-Télévision, étaient tout à la gloire du Maréchal Mobutu. Mais leur modernisation est bluffante, elles peuvent être adaptées et améliorées, et on peut les multiplier à l’envi pour discréditer le travail des journalistes, cibles très à la mode. Cela a permis également de montrer aux Vénézuéliens de faux JT étrangers, notamment américains et donc largement hostiles à Maduro, parlant positivement de leur pays, deepfakes à l’appui. De quoi ajouter de la confusion à la confusion.

En Turquie, les élections présidentielles de mai 2023 ont été entachées par des deepfakes. Un candidat de l’opposition, Muharrem Ince, s’est ainsi retiré après avoir été la cible d’une campagne de dénigrement en ligne, qui comprenait notamment des images truquées de lui avec des femmes ou au volant de voitures de luxe. Plus étonnant encore, en plein meeting, Recep Tayyip Erdogan a diffusé un clip de quatorze secondes, présenté comme la preuve que son principal rival, Kemal Kiliçdaroglu, « avance main dans la main avec le groupe armé PKK » . Kemal Kilicdaroglu, principal rival du président, a ensuite affirmé que des pirates étrangers, recrutés par le camp Erdogan, préparaient des deepfakes, vidéos ou sons manipulés grâce à l'intelligence artificielle, afin de le discréditer, ciblant principalement la Russie. Autre exemple, en 2024, le président turc Recep Tayyip Erdogan menait

« une bataille pour reprendre le contrôle d'Istanbul lors d'élections locales très disputées … Mais alors que le parti AK d'Erdogan intensifie ses efforts pour reprendre le contrôle de Istanbul, une vidéo générée par l'intelligence artificielle du maire sortant Ekrem Imamoglu félicitant Erdogan pour ses réalisations à Istanbul, a circulé sur les médias sociaux … Les médias indépendants ont alors mis en garde contre la menace de fausses nouvelles, car les médias traditionnels, qui sont principalement sous le contrôle du gouvernement , ne vérifiaient pas l'authenticité des vidéos.» .

Le secteur des médias indépendants ferait face à une pression des autorités turques et une grande partie de leurs nouvelles seraient bloquées sur les médias sociaux. Une tendance confirmée par Emma Sinclair-Webb, chercheuse principale en Turquie de Human Rights Watch :

« Ce que nous avons vu, c'est que très, très souvent du matériel, principalement des nouvelles sur les médias sociaux, est supprimé et bloqué en ligne … Il est très inquiétant de voir que les autorités sont prêtes à réprimer la liberté d'expression, mais les entreprises de médias sociaux elles-mêmes ne sont pas assez robustes pour résister à cette pression » .

La Turquie est ainsi un bon exemple de guerre de récits, en période électorale, appuyé par des deepfakes. Mais ces derniers ne montrent une efficacité que grâce aux pressions gouvernementales sur les médias de presse et les médias sociaux. La pression sur ces derniers est bien réelle. Exemple avec le blocage en 2023 par Elon Musk de quatre comptes sur X, car il était effrayé par la menace du régime de bloquer son réseau social dans tout le pays. Car Erdogan ne plaisante pas et l’a montré en 2024, quand Instagram, pourtant utilisé par 57 millions de Turcs, a été complètement bloqué par les autorités qui n'ont pas donné de raison claire mais le président avait accusé le réseau social de censurer les critiques contre Israël et certains messages de soutien aux Palestiniens. Il a été jusqu'à parler de "fascisme numérique". Voilà donc un exemple de pays qui montre combien la censure de deepfakes par les plateformes n’est pas la panacée, ces dernières n’étant pas en mesure de tenir tête à un régime autoritaire, à la tête d’un juteux marché de 80 millions d’âmes.

De plus, l’efficacité de deepfakes dépend beaucoup des contextes politiques locaux. En 2023, au Bangladesh, pays en proie à de vastes émeutes contre le régime, des dizaines d’experts, de spécialistes et autres écrivains ont été créés par l’IA pour défendre le bilan du gouvernement ou accuser des pays étrangers d’être responsables des problèmes économiques du pays. Faux articles, fausses photos. Le tout propagé par des médias nationaux. Peine perdue, la première ministre Sheikh Hasina devra démissionner. Il faut dire que cette autocrate était au pouvoir depuis 15 ans et que, quel qu’ait pu être sa communication, il était trop tard pour convaincre un peuple écœuré et révolté.

Comme le précise Danielle Citron, spécialiste des deepfakes et professeure à la Faculté de droit de l'Université de Virginie :

« La possibilité d'influencer le résultat d'une élection est réelle, en particulier si l'auteur est capable de programmer la diffusion de manière à ce qu'il y ait suffisamment de temps pour que le contenu trafiqué circule, mais pas assez pour que la victime puisse le démentir efficacement – à supposer qu'il puisse être démenti » .

L’efficacité politique d’un deepfake dépend donc non seulement du contexte politique mais aussi du timing de sa publication et sans doute de la manière dont il est diffusé. L’Inde est ainsi un laboratoire pour les deepfakes publiés en période électorale. Dans cet immense pays, où la désinformation est largement utilisée, et où une grande partie de la population est peu éduquée aux subtilités des médias numériques, on a pu voir

« Des hommes politiques défunts ressuscités pour soutenir un candidat dans le Tamil Nadu ; un dirigeant d’un parti musulman entonnant des chants de dévotion hindous ; des stars de Bollywood d’habitude très discrètes, Ranveer Singh et Aamir Khan, critiquant ouvertement le premier ministre indien et apportant leur soutien au Congrès, le principal parti d’opposition… Les deepfakes (ou hypertrucages), ces vidéos reproduisant à s’y méprendre visages et voix et pouvant servir à propager de la désinformation, ont envahi les réseaux sociaux, comme les fake news avaient déjà marqué la campagne de 2019. »

Plus efficace encore, un message vocal personnalisé du président nationaliste Narendra Modi adressé à chaque électeur en l’appelant par son nom, via Whatsapp. L’avatar du président leur parle des avantages gouvernementaux qu’ils ont reçus et demande leur vote. Le tout réalisé par l’équipe de communication du président, sans que ce dernier n’ait à y travailler une seconde. C’est une nouvelle méthode pour parler directement aux électeurs via des chatbots élaborés, qui leurs fait croire qu’il les connaît et connaît leurs problèmes. Pour Suhasini Raj, qui a écrit un article sur ces méthodes pour The New-York Times,

« Pour avoir un aperçu de l’avenir de l’intelligence artificielle dans les campagnes électorales, regardez ce qu’il se passe en Inde » .

Car M. Modi n’est pas le seul à utiliser ce système qui pourrait faire des émules dans d’autres pays. La méthode, qui rappelle celle de Cambridge Analytica aux USA et en Grande-Bretagne en 2016, pourrait amener à la propagation de mensonges et de désinformations personnalisés juste pour gagner une élection. Pour Nicolas Obin, Maître de conférences à Sorbonne Université et chercheur à l’Ircam (Institut de recherche et coordination acoustique/musique), il existe des manipulations pernicieuses,

« comme la manipulation des émotions, qui s’adresse à nos affects. Par exemple, un assistant vocal pourrait avoir des interactions émotionnelles ou expressives et influencer nos comportements en infléchissant nos émotions, ou en nous incitant à acheter quelque chose, etc. En politique, un même discours pourrait être adressé à chaque citoyen avec des variations de ton adapté pour obtenir un effet optimal de persuasion » .

Là on entrerait dans la manipulation caractérisée.